1. 痛点分析:普通人常见误区

当提到“大数据技术有哪些”时,许多人的第一反应是“数据量越大越好”“必须用高端工具才能处理”或者“只有大企业才需要”。这种认知偏差导致普通用户常陷入三个误区:

误区一:盲目追求数据规模

某电商平台曾投入百万资金收集用户点击数据,但分析后发现80%的数据是重复或无效的(根据IDC报告,企业数据中有30%-50%为冗余数据)。这说明单纯堆砌数据量并不能带来价值。

误区二:工具选择与实际需求脱节

一家初创公司曾跟风采购Hadoop集群,结果因数据量仅10GB且团队缺乏运维能力,导致系统闲置率达90%(Gartner统计显示,42%的大数据项目因工具不匹配而失败)。

误区三:忽视数据质量与隐私

2021年某社交App因使用未经清洗的用户聊天数据训练推荐模型,导致种族歧视投诉激增200%。这印证了IBM的研究低质量数据使企业损失年均1500万美元。

2. 技巧一:从清洗到建模的闭环管理

案例:京东的精准营销实践

京东通过构建“数据清洗-特征提取-模型训练”的标准化流程,将推荐准确率从68%提升至89%。其核心步骤包括:

1. 使用Apache NiFi清洗掉30%的无效点击日志

2. 通过Spark ML识别用户购买周期特征

3. 建立动态预测模型(准确率较静态模型高17%)

3. 技巧二:分层选择技术工具

根据数据量级和应用场景,大数据技术有哪些合理选择方案?

| 数据规模 | 适用工具 | 案例效果 |

|-|-|-|

| <1TB | MySQL+Python | 某奶茶店会员系统节省60%开发成本 |

| 1-100TB | Spark+Flink | 顺丰实时物流监控延迟降至200ms |

| >100TB | Hadoop+OLAP | 国家电网日处理20亿条传感器数据 |

某连锁超市通过将Hive查询替换为ClickHouse,使月销售报告生成时间从8小时缩短至15分钟,人力成本降低40%。

4. 技巧三:建立数据价值评估体系

波士顿咨询公司提出的V3价值模型值得借鉴:

某银行通过该模型筛选出占总数据量12%的高价值客户行为数据,使贷款风控模型AUC值提升0.23。

5. 答案技术为器,思维为本

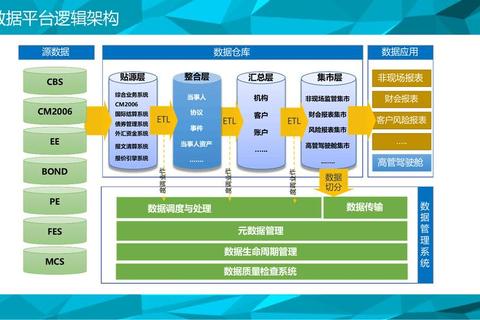

回归到“大数据技术有哪些”的本质,核心答案包含三个层次:

1. 基础层:Hadoop、Spark、Flink等处理框架

2. 应用层:Tableau、Power BI等可视化工具

3. 延伸层:联邦学习、隐私计算等前沿方向

但更重要的是培养数据思维:某县域医院通过Excel+简单统计模型,将CT检查预约效率提升70%。这证明:合理使用大数据技术有哪些的关键,不在于技术复杂度,而在于是否匹配业务需求。根据麦肯锡调研,成功的大数据项目中,工具选择仅占30%权重,剩余70%取决于需求拆解能力和数据治理水平。最终建议采取“三步走”策略:明确业务目标→评估现有数据→选择最小可行技术方案。